La Data Scienceیا علم داده، یک علم نسبتاً جدید است، در واقع حدود پنجاه سال است که وجود دارد. این از نیاز به ایجاد نظم در یک زمینه بسیار زنده و به سرعت در حال تکامل ناشی می شود. رشد حجم داده ها، امکان و توانایی معنا بخشیدن به داده ها، باعث شده است Data Science.

از لحاظ تاریخی، داده ها اغلب به عنوان نوعی محصول ثانویه هر فرآیند تلقی می شوند. هر کسی که در طول قرن ها متعهد به جمع آوری داده ها بوده است، این کار را عمدتاً برای راحتی خود انجام داده است، اغلب بدون اینکه تصور کند که امروزه ارزش اقتصادی را می توان به مجموعه ای از داده ها نسبت داد. برای مثال، اگر به مزرعهای فکر کنیم که ممکن است طی سالها اطلاعاتی در مورد محصولات، رویدادها، کاشت و غیره جمعآوری کرده باشد، شاید میتوانست این کار را برای بایگانی کردن تاریخچه شرکت خود انجام دهد. اگر همه مزارع این روش را انجام میدادند، شرکتهای کود اکنون میتوانستند از آن برای اهداف تحقیقاتی یا بازاریابی بهره ببرند.

آن که با آن سروکار دارد Data Science، او نامیده می شود دانشمند داده: در حال حاضر یکی از پرطرفدارترین افراد حرفه ای در دنیای کار است.

وظیفه دانشمند داده تجزیه و تحلیل داده ها به منظور شناسایی مدل های موجود در آنها است، یعنی آنچه من داده های موجود را از طریق روند بیان می کنم. شناسایی این مدل ها برای اهداف مشتری کاربردی است: شرکت، نهاد عمومی و غیره ...

در سالهای اخیر، یک مدل بازاریابی داده به طور فزایندهای خود را تثبیت کرده است، جایی که شخصی علاقهمند به فروش داده و شخص دیگری به خرید آن است.

شرکتهای متخصص در تولید دادهها متولد شدند و شرکتهایی در خرید و فروش پس از عملیات تمیز کردن و بازپردازی مناسب تخصص داشتند. اگر پس از آن به قوانین حفظ حریم خصوصی فکر کنیم، متوجه پیچیدگی موضوع می شویم. امروزه قوانین سختگیرانه ای وجود دارد که استفاده آگاهانه و محترمانه از اطلاعات را می طلبد.

پروژه ای از Data Science معمولاً شامل مراحل زیر است:

در هر مرحله دانشمند داده با بخش های خاص شرکت در تعامل است و بنابراین می توان گفت که دانشمند داده کاملاً با واقعیت شرکت ادغام شده است.

با پیشرفت تکنولوژی، دانشمند داده او اغلب خود را با مشکلات کلان داده و هوش مصنوعی مواجه کرده است.

وقتی در مورد Big Data صحبت می کنیم، به داده هایی اشاره می کنیم که دارای تنوع بسیار زیادی هستند و با حجم فزاینده و با سرعت بیشتری به دست می آیند. این مفهوم همچنین به عنوان قانون سه Vs شناخته می شود که شامل انتخاب سه عبارت است که پدیده کلان داده را در ویژگی های اساسی آن مشخص می کند:

در واقع، ویژگی های دیگری نیز در طول زمان اضافه شده است، مانند صحت داده ها برای شناسایی قابلیت اطمینان و قابلیت اطمینان داده ها.

حجم زیادی از دادهها که با سرعت زیاد به دست میآیند و با تنوع زیاد مشخص میشوند، لزوماً منجر به مشکلات سازماندهی دادهها میشوند.

استقبال از آنها و سپس پردازش آنها؟ ساختار آنها و سپس پردازش آنها؟

پارادایم های مختلف سازماندهی سیستم های داده ای متولد شدند که در طول زمان خود را تثبیت کردند:

در حال حاضر اینها پرکاربردترین پارادایم ها هستند و در بسیاری از موارد راه حل یکپارچه سازی غالب است، یعنی پروژه های مختلف می توانند از متدولوژی های انباشت متفاوت استفاده کنند و سپس در زمان بعدی ادغام شوند. ممکن است موقعیتهایی وجود داشته باشد که در آن دادههای مختلف با پارادایمهای مختلف جمعآوری میشوند، یا مجموعههای مختلف میتوانند مراحل پیوسته چرخه زندگی یکسان را تشکیل دهند.

علیرغم مفید بودن زیاد آنها، ما به خوبی می دانیم که ماشین های پردازش یا رایانه احمقانه هستند. به این معنا که اگر انسان نتواند یک مسئله را تجزیه و تحلیل کند، یک الگوریتم را فرموله کند و آن را در یک برنامه رمزگذاری کند، کاری نمی تواند انجام دهد.

این همیشه همینطور بوده است، تا زمانی که ما شروع به صحبت کردیم هوش مصنوعی. در واقع، هوش مصنوعی عبارت است از القای نوعی استدلال خودانگیخته در ماشین، که می تواند آن را به حل مسائل به طور مستقل، یعنی بدون هدایت مستقیم انسان، سوق دهد.

چندین سال طول کشید تا این عبارت "نوعی استدلال خود به خودی را در ماشین القا کند«یعنی چندین سال طول کشید تا از وضعیت آموزش کامل «اجباری» ماشین به شرایط خودآموزی رسیدیم. به عبارت دیگر، ماشین توانسته است خود یاد بگیرد، یاد بگیرد. بنابراین ما به آن رسیده ایم فراگیری ماشین.

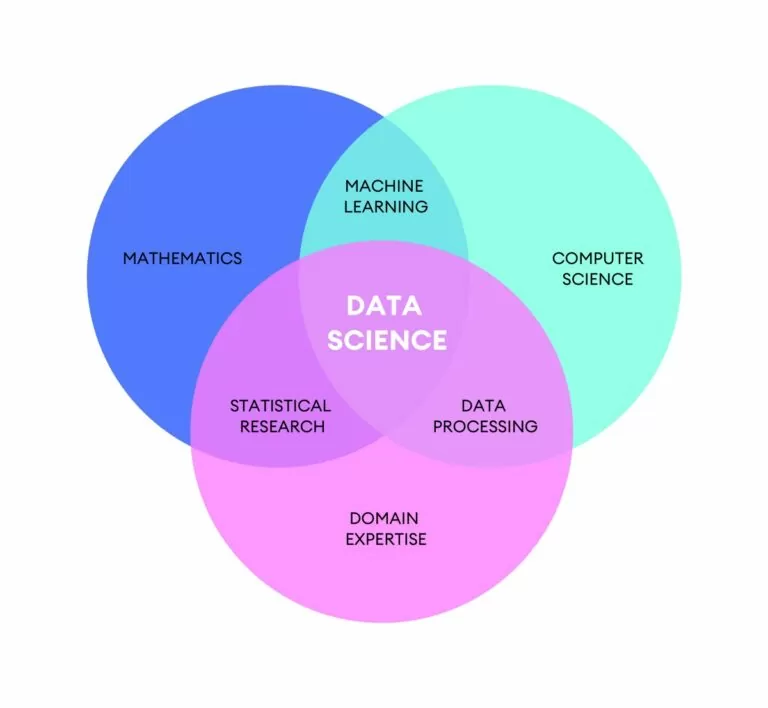

یادگیری ماشینی شاخه ای از هوش مصنوعی است که در آن برنامه نویس ماشین را در مرحله آموزشی بر اساس مطالعه داده های تاریخی هدایت می کند. در پایان این مرحله آموزشی، مدلی تولید میشود که با دادههای جدید میتواند در حل مسائل کاربرد داشته باشد.

من به رویکرد کلاسیک، جایی که دانشمند داده برای آن کار می کرد، احترام می گذارم defiبا الگوریتم های حل nish، ماشین کشف خواهد کرد که چه چیزی مدل را می سازد. دانشمند داده باید از سازماندهی مراحل آموزشی مؤثرتر، با داده های غنی تر و مهم تر، و تأیید اعتبار مدل های تولید شده با آزمایش آنها مراقبت کند.

به لطف یادگیری ماشینی، سیستمهایی که در دستگاههای تلفن همراه، اینترنت، اتوماسیون خانگی استفاده میکنیم (یا به نظر میرسد) بیشتر و بیشتر هوشمند هستند. یک سیستم، همانطور که کار می کند، همچنین ممکن است بتواند داده هایی را در مورد آن و کاربرانی که از آن استفاده می کنند جمع آوری کند، سپس از آنها در مرحله آموزش استفاده کند و سپس پیش بینی ها را بیشتر بهبود بخشد.

Ercole Palmeri: معتاد به نوآوری

مایکروسافت اکسل ابزار مرجع برای تجزیه و تحلیل داده ها است، زیرا ویژگی های بسیاری را برای سازماندهی مجموعه داده ها ارائه می دهد.

Walliance، سیمکارت و پلتفرم در میان پیشتازان اروپا در زمینه سرمایهگذاری جمعی املاک و مستغلات از سال 2017، تکمیل…

Filament یک چارچوب توسعه لاراول "شتاب یافته" است که چندین مولفه تمام پشته را ارائه می دهد. طراحی شده است تا فرآیند…

من باید برگردم تا تکامل خود را کامل کنم: خودم را در کامپیوتر فرافکنی می کنم و به انرژی خالص تبدیل می شوم. پس از استقرار در…

Google DeepMind نسخه بهبودیافته ای از مدل هوش مصنوعی خود را معرفی می کند. مدل جدید بهبود یافته نه تنها…

لاراول که به دلیل نحو زیبا و ویژگی های قدرتمندش معروف است، همچنین پایه ای محکم برای معماری مدولار فراهم می کند. آنجا…

سیسکو و Splunk به مشتریان کمک می کنند تا سفر خود را به مرکز عملیات امنیتی (SOC) آینده با…

باج افزار در دو سال گذشته بر اخبار غالب بوده است. اکثر مردم به خوبی می دانند که حملات…